Jei nesate kūrėjas, kodėl jūs norėtumėte paleisti atvirojo kodo AI modelį savo namų kompiuteryje?

Pasirodo, yra keletas gerų priežasčių. Kadangi nemokami atvirojo kodo modeliai tampa geresni nei bet kada anksčiau, o naudoti paprasta, su minimaliais aparatūros reikalavimais – dabar puikus metas tai išbandyti.

Štai keletas priežasčių, kodėl atvirojo kodo modeliai yra geresni nei mokėti 20 USD per mėnesį „ChatGPT“, „Perplexity“ ar „Google“:

- Tai nemokama. Jokių abonentinių mokesčių.

- Jūsų duomenys lieka jūsų kompiuteryje.

- Veikia neprisijungus, nereikia interneto.

- Galite išmokyti ir pritaikyti savo modelį konkretiems naudojimo atvejams, pavyzdžiui, kūrybiniam rašymui ar… na, bet kam.

Įėjimo barjeras sugriuvo. Dabar yra specializuotų programų, leidžiančių naudotojams eksperimentuoti su dirbtiniu intelektu be jokio vargo savarankiškai diegti bibliotekas, priklausomybes ir papildinius. Tai gali padaryti beveik visi, turintys gana neseną kompiuterį: vidutinės klasės nešiojamasis ar stalinis kompiuteris su 8 GB vaizdo atmintimi gali veikti stebėtinai galingus modelius, o kai kurie modeliai veikia su 6 GB ar net 4 GB VRAM. O Apple atveju bet kuris M serijos lustas (kelerių pastarųjų metų) galės paleisti optimizuotus modelius.

Programinė įranga nemokama, sąranka trunka kelias minutes, o pats bauginantis veiksmas – pasirinkti, kurį įrankį naudoti – kyla į paprastą klausimą: ar jums labiau patinka spustelėti mygtukus ar įvesti komandas?

Turinys:

Toggle„LM Studio“ prieš Ollamą

Vietinėje AI erdvėje dominuoja dvi platformos, kurios sprendžia problemą iš priešingų kampų.

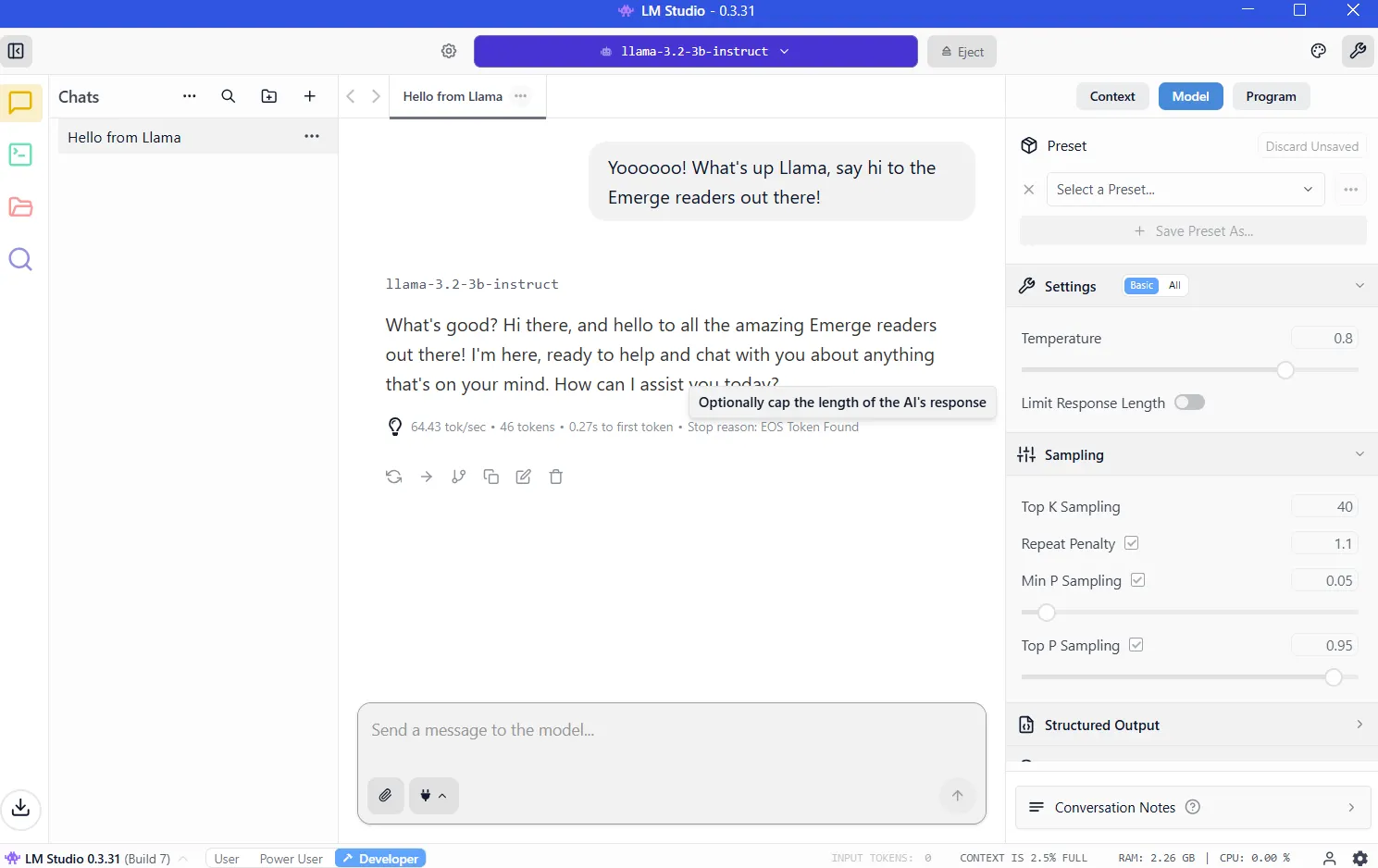

LM Studio viską apgaubia nugludinta grafine sąsaja. Galite tiesiog atsisiųsti programą, naršyti integruotą modelių biblioteką, spustelėti, kad įdiegtumėte, ir pradėti kalbėtis. Patirtis atspindi naudojant „ChatGPT“, išskyrus tai, kad apdorojimas vyksta jūsų aparatinėje įrangoje. „Windows“, „Mac“ ir „Linux“ naudotojai turi tą pačią sklandžią patirtį. Naujokams tai yra akivaizdus atspirties taškas.

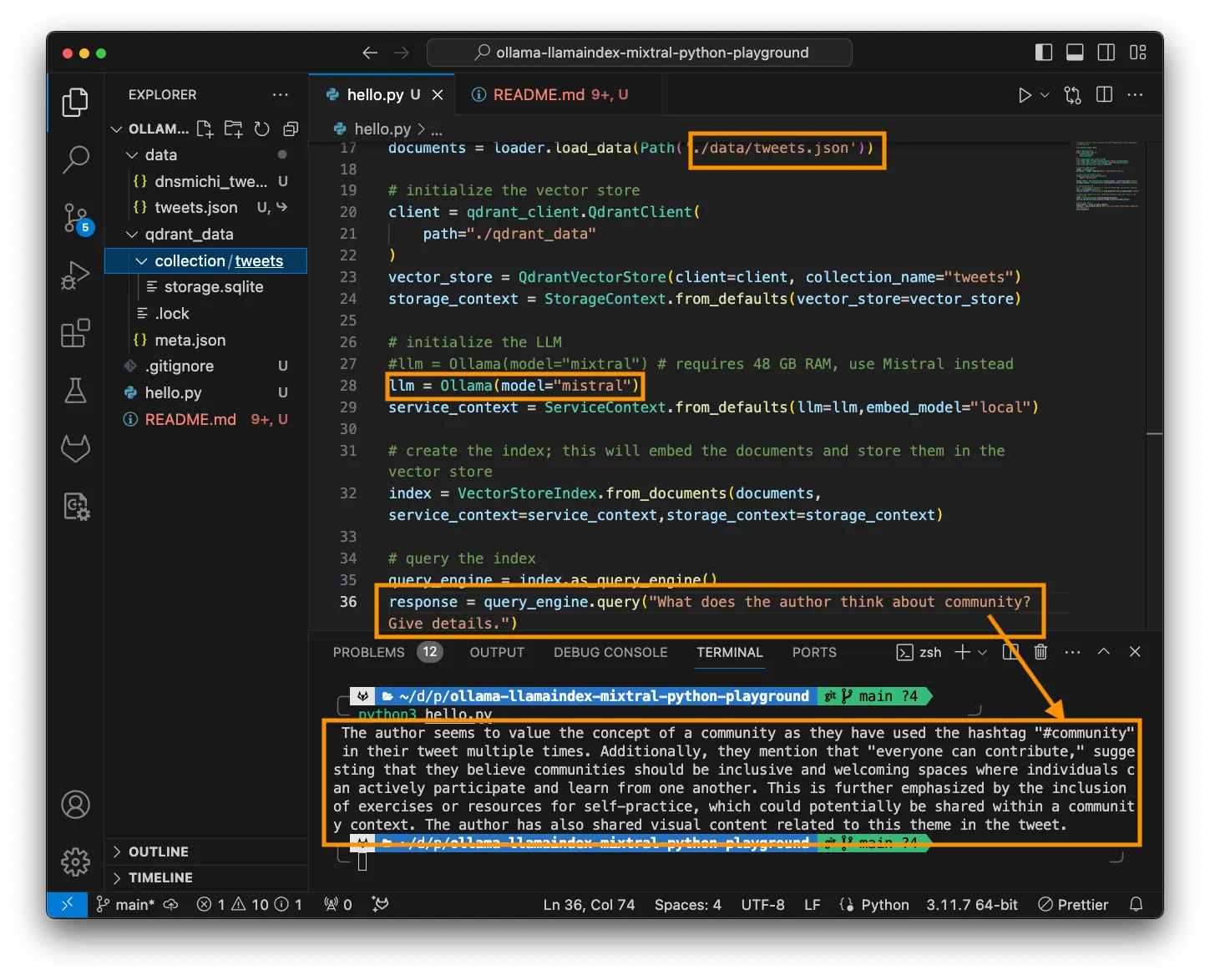

„Ollama“ skirta kūrėjams ir patyrusiems vartotojams, gyvenantiems terminale. Įdiekite naudodami komandinę eilutę, ištraukite modelius naudodami vieną komandą, tada sukurkite scenarijų arba automatizuokite pagal savo skonį. Jis lengvas, greitas ir puikiai integruojamas į programavimo darbo eigą.

Mokymosi kreivė yra statesnė, tačiau atlygis yra lankstumas. Tai taip pat yra tai, ką galingi vartotojai pasirenka dėl universalumo ir pritaikymo.

Abu įrankiai paleidžia tuos pačius pagrindinius modelius, naudojant identiškus optimizavimo variklius. Veikimo skirtumai yra nereikšmingi.

LM studijos nustatymas

Apsilankykite https://lmstudio.ai/ ir atsisiųskite savo operacinei sistemai skirtą diegimo programą. Failas sveria apie 540 MB. Paleiskite diegimo programą ir vykdykite nurodymus. Paleiskite programą.

1 patarimas: jei klausia, kokio tipo vartotojas esate, pasirinkite „kūrėjas“. Kiti profiliai tiesiog slepia parinktis, kad būtų lengviau.

2 patarimas: rekomenduosime atsisiųsti OSS, OpenAI atvirojo kodo AI modelį. Vietoj to, kol kas spustelėkite „praleisti“; yra geresnių, mažesnių modelių, kurie atliks geresnį darbą.

VRAM: Vietinio AI paleidimo raktas

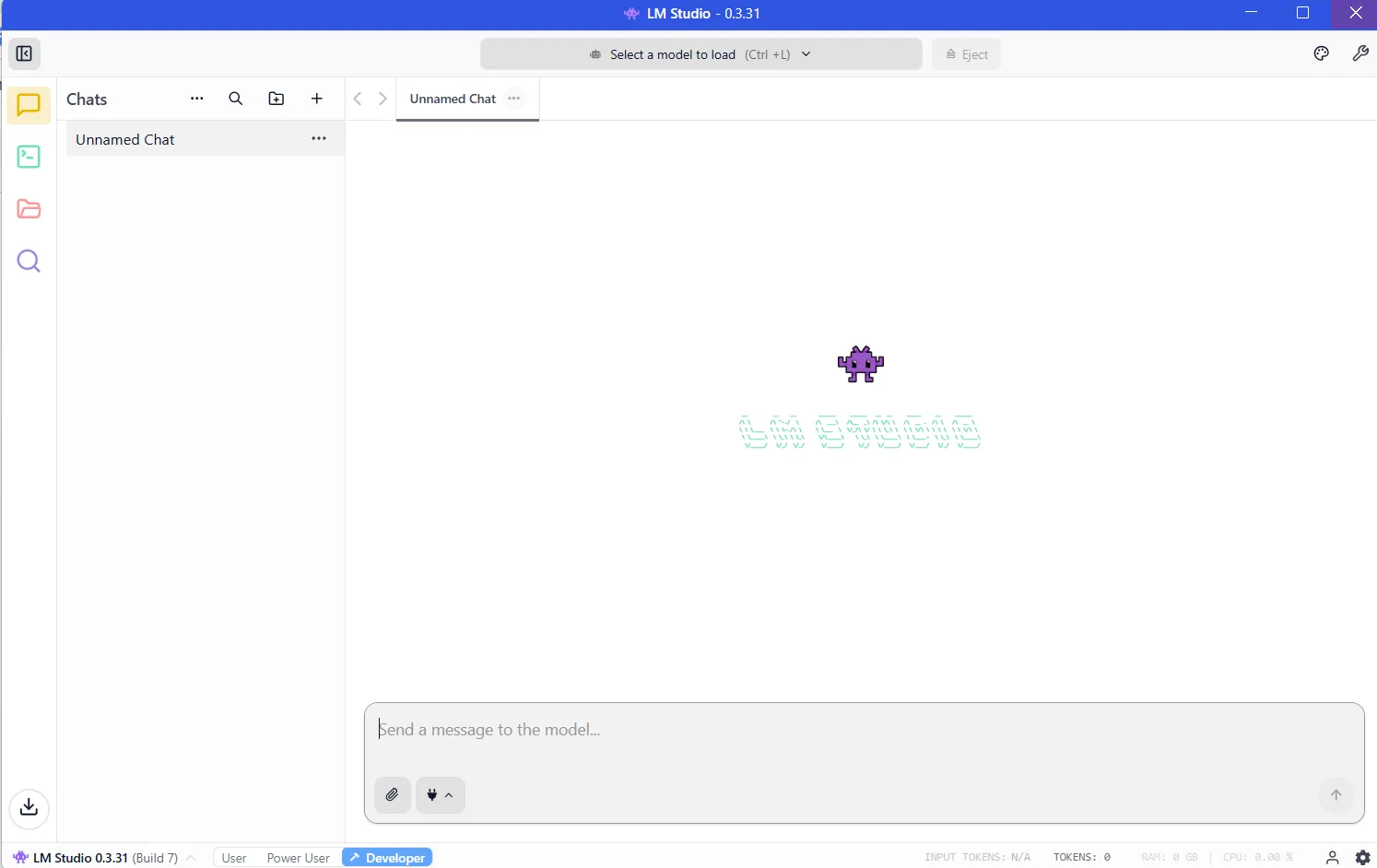

Įdiegę LM Studio, programa bus paruošta paleisti ir atrodys taip:

Dabar turite atsisiųsti modelį, kad jūsų LLM pradėtų veikti. Ir kuo galingesnis modelis, tuo daugiau išteklių jam reikės.

Svarbiausias išteklius yra VRAM arba vaizdo atmintis jūsų vaizdo plokštėje. LLM įkeliama į VRAM išvados metu. Jei neturite pakankamai vietos, našumas žlunga ir sistema turi naudoti lėtesnę sistemos RAM. Norėsite to išvengti, turėdami pakankamai VRAM modeliui, kurį norite paleisti.

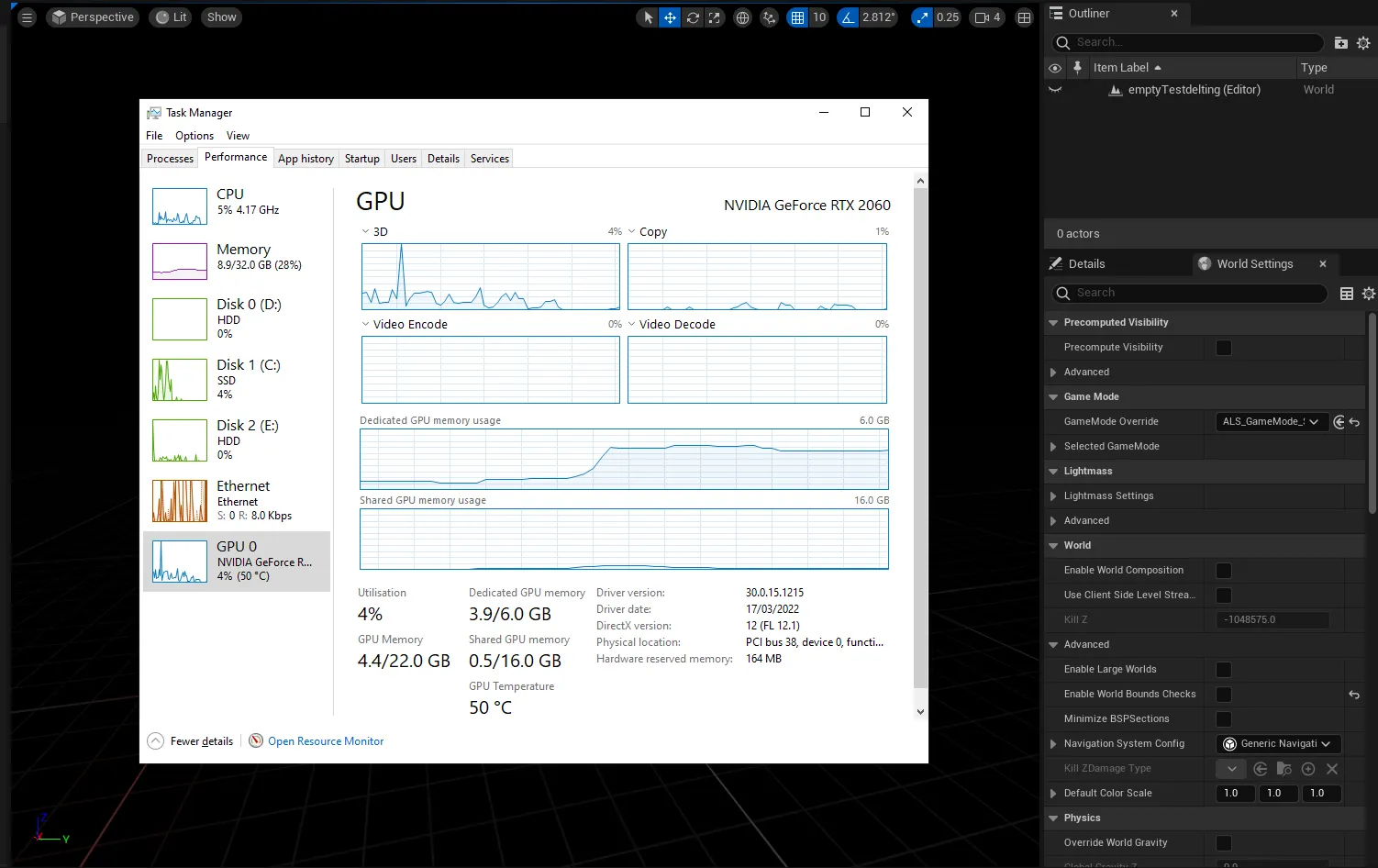

Norėdami sužinoti, kiek turite VRAM, galite įvesti „Windows“ užduočių tvarkyklę (control+alt+del) ir spustelėti GPU skirtuką, įsitikindami, kad pasirinkote skirtą vaizdo plokštę, o ne integruotą „Intel“ / AMD procesoriaus grafiką.

Skiltyje „Dedikuota GPU atmintis“ pamatysite, kiek turite VRAM.

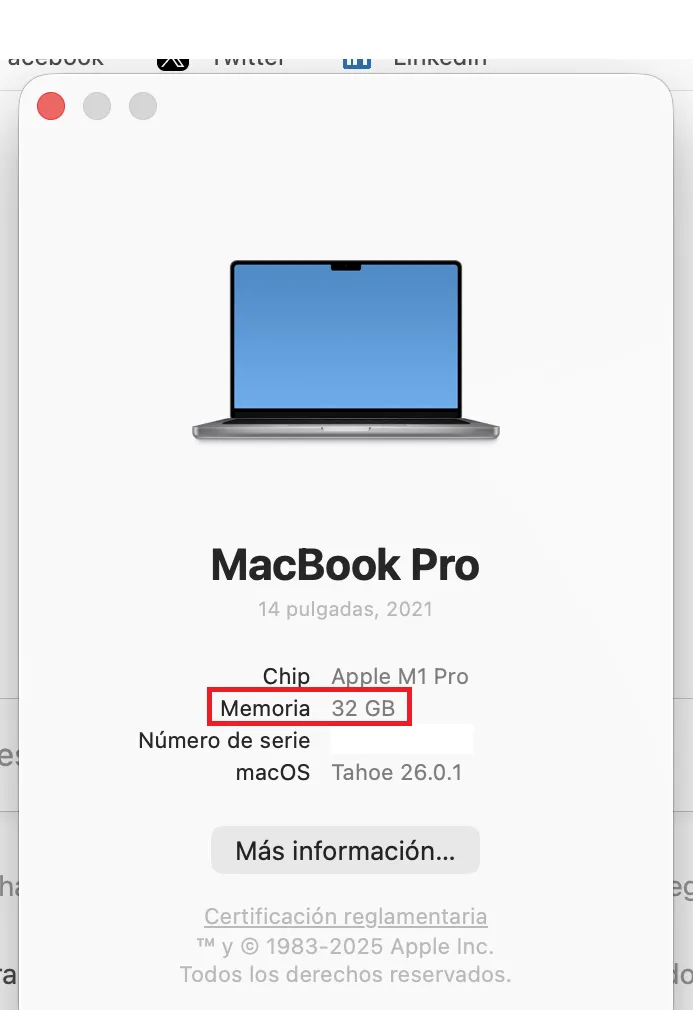

M serijos „Mac“ kompiuteriuose viskas yra lengviau, nes jie dalijasi RAM ir VRAM. Įrenginio RAM kiekis bus lygus VRAM, kurią galite pasiekti.

Norėdami patikrinti, spustelėkite „Apple“ logotipą, tada spustelėkite „Apie“. Matote atmintį? Tiek turite VRAM.

Jums reikės bent 8 GB VRAM. 7–9 milijardų parametrų diapazono modeliai, suglaudinti naudojant 4 bitų kvantavimą, patogiai telpa ir užtikrina puikų našumą. Sužinosite, ar modelis yra kiekybiškai įvertintas, nes kūrėjai paprastai jį atskleidžia pavadinime. Jei pavadinime matote BF, FP arba GGUF, vadinasi, žiūrite į kvantuotą modelį. Kuo mažesnis skaičius (FP32, FP16, FP8, FP4), tuo mažiau išteklių jis sunaudos.

Tai ne nuo obuolių iki obuolių, bet įsivaizduokite, kad kvantavimas yra jūsų ekrano skiriamoji geba. Tą patį vaizdą matysite 8K, 4K, 1080p arba 720p. Galėsite suvokti viską, kad ir kokia būtų skiriamoji geba, tačiau priartinus ir išrankus smulkmenoms paaiškės, kad 4K vaizdas turi daugiau informacijos nei 720p, tačiau jam atvaizduoti reikės daugiau atminties ir resursų.

Tačiau idealiu atveju, jei esate tikrai rimtas, turėtumėte nusipirkti gražų žaidimų GPU su 24 GB VRAM. Nesvarbu, ar jis naujas, ar ne, ir nesvarbu, koks jis greitas ar galingas. AI šalyje VRAM yra karalius.

Sužinoję, kiek VRAM galite bakstelėti, galite išsiaiškinti, kuriuos modelius galite paleisti, apsilankę VRAM skaičiuoklėje. Arba tiesiog pradėkite nuo mažesnių modelių, kuriuose yra mažiau nei 4 milijardai parametrų, o tada pereikite prie didesnių modelių, kol kompiuteris praneš, kad nepakanka atminties. (Daugiau apie šią techniką šiek tiek.)

Atsisiunčiami modeliai

Kai žinosite savo aparatinės įrangos ribas, laikas atsisiųsti modelį. Spustelėkite didinamojo stiklo piktogramą kairėje šoninėje juostoje ir ieškokite modelio pagal pavadinimą.

„Qwen“ ir „DeepSeek“ yra geri modeliai, kuriais galite pradėti kelionę. Taip, jie kinai, bet jei nerimaujate, kad jus šnipins, galite būti ramūs. Kai vykdote savo LLM vietoje, niekas nepalieka jūsų kompiuterio, todėl jūsų nežiūrės nei Kinijos, nei JAV vyriausybė, nei jokie verslo subjektai.

Kalbant apie virusus, viskas, ką rekomenduojame, ateina per Hugging Face, kur programinė įranga akimirksniu patikrinama, ar nėra šnipinėjimo ir kitų kenkėjiškų programų. Tačiau už tai, ko verta, geriausias amerikietiškas modelis yra Meta's Llama, todėl galbūt norėsite jį pasirinkti, jei esate patriotas. (Paskutinėje dalyje siūlome kitas rekomendacijas.)

Atminkite, kad modeliai veikia skirtingai, atsižvelgiant į mokymo duomenų rinkinį ir koregavimo metodus, naudojamus jiems sukurti. Nepaisant Elono Musko Groko, nėra tokio dalyko kaip nešališkas modelis, nes nėra tokio dalyko kaip nešališka informacija. Taigi rinkitės nuodus atsižvelgdami į tai, kiek jums rūpi geopolitika.

Kol kas atsisiųskite ir 3B (mažesnis, mažiau pajėgus modelis), ir 7B versijas. Jei galite paleisti 7B, ištrinkite 3B (ir pabandykite atsisiųsti ir paleisti 13B versiją ir pan.). Jei negalite paleisti 7B versijos, ištrinkite ją ir naudokite 3B versiją.

Atsisiuntę įkelkite modelį iš skyriaus „Mano modeliai“. Pasirodo pokalbių sąsaja. Įveskite žinutę. Modelis atsako. Sveikiname: naudojate vietinį AI.

Suteikite savo modeliui prieigą prie interneto

Vietiniai modeliai negali naršyti internete. Jie yra izoliuoti pagal dizainą, todėl jūs kartosite su jais remdamiesi jų vidinėmis žiniomis. Jie puikiai tiks rašant trumpas istorijas, atsakant į klausimus, atliekant kodavimą ir pan. Tačiau jie nepateiks jums naujausių naujienų, nepasakys orų, netikrins el. pašto ir nesuplanuos susitikimų.

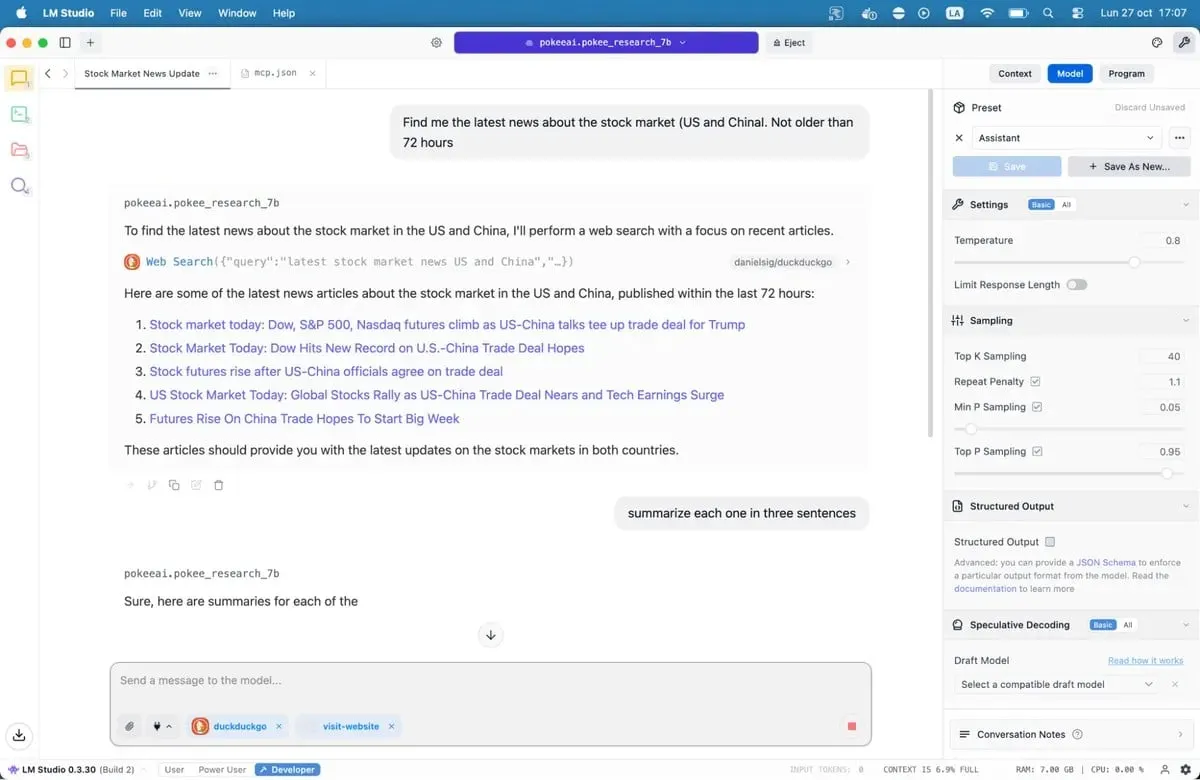

Modelio konteksto protokolo serveriai tai pakeičia.

MCP serveriai veikia kaip tiltai tarp jūsų modelio ir išorinių paslaugų. Norite, kad jūsų AI ieškotų „Google“, patikrintų „GitHub“ saugyklas ar skaitytų svetaines? MCP serveriai tai leidžia. LM Studio pridėjo MCP palaikymą 0.3.17 versijoje, pasiekiamą per skirtuką Programa. Kiekvienas serveris pateikia konkrečius įrankius – žiniatinklio paiešką, prieigą prie failų, API iškvietimus.

Jei norite suteikti modeliams prieigą prie interneto, mūsų išsamiame MCP serverių vadove pateikiamas sąrankos procesas, įskaitant populiarias parinktis, pvz., žiniatinklio paiešką ir prieigą prie duomenų bazės.

Išsaugokite failą ir LM Studio automatiškai įkels serverius. Kai kalbatės su savo modeliu, dabar jis gali iškviesti šiuos įrankius tiesioginiams duomenims gauti. Jūsų vietinis AI ką tik įgijo supergalių.

Mūsų rekomenduojami modeliai 8 GB sistemoms

Jums yra prieinama šimtai LLM – nuo pažangių variantų iki patobulintų modelių, skirtų specializuotiems naudojimo atvejams, pvz., kodavimui, medicinai, vaidmenų žaidimui ar kūrybiniam rašymui.

Geriausiai koduoti: Nemotron arba DeepSeek yra gerai. Jie nesugadins jūsų proto, bet puikiai veiks generuojant kodą ir derinant, o tai pralenks daugumą programavimo etalonų alternatyvų. „DeepSeek-Coder-V2 6.7B“ siūlo dar vieną tvirtą parinktį, ypač kuriant daugiakalbį.

Geriausiai tinka bendroms žinioms ir samprotavimams: Qwen3 8B. Modelis turi stiprias matematines galimybes ir efektyviai tvarko sudėtingas užklausas. Jo kontekstinis langas talpina ilgesnius dokumentus neprarandant nuoseklumo.

Geriausiai tinka kūrybiniam rašymui: DeepSeek R1 variantai, bet jums reikia sudėtingos ir greitos inžinerijos. Taip pat yra necenzūruotų smulkių melodijų, tokių kaip „ištrinta-necenzūruota-NEO-Imatrix“ OpenAI GPT-OSS versija, kuri tinka siaubui; arba Dirty-Muse-Writer, kuris tinka erotikai (taip sakoma).

Geriausiai tinka pokalbių robotams, vaidmenų žaidimams, interaktyviai fantastikai, klientų aptarnavimui: Mistral 7B (ypač Undi95 DPO Mistral 7B) ir Llama variantai su dideliais kontekstiniais langais. MythoMax L2 13B išlaiko charakterio bruožus ilgų pokalbių metu ir natūraliai pritaiko toną. Kituose NSFW vaidmenų žaidimuose yra daug galimybių. Galbūt norėsite patikrinti kai kuriuos šiame sąraše esančius modelius.

Dėl MCP: Jan-v1-4b ir Pokee Research 7b yra puikūs modeliai, jei norite išbandyti ką nors naujo. „DeepSeek R1“ yra dar vienas geras pasirinkimas.

Visus modelius galima atsisiųsti tiesiai iš LM Studio, jei tik ieškote jų pavadinimų.

Atminkite, kad atvirojo kodo LLM aplinka greitai keičiasi. Kas savaitę išleidžiami nauji modeliai, kurių kiekvienas teigia patobulinimus. Galite juos patikrinti LM Studio arba naršyti po įvairias Hugging Face saugyklas. Išbandykite parinktis patys. Dėl nepatogios formuluotės, pasikartojančių modelių ir faktinių klaidų greitai išryškėja netinkami atitikmenys. Geri modeliai jaučiasi kitaip. Jie samprotauja. Jie jus nustebina.

Technika veikia. Programinė įranga paruošta. Tikriausiai jūsų kompiuteryje jau yra pakankamai energijos. Belieka tik pabandyti.

Apskritai protingas Naujienlaiškis

Savaitinė AI kelionė, pasakojama Geno, generatyvaus AI modelio.